อาลีบาบา คลาวด์ เปิด ดาต้าเซ็นเตอร์ แห่งที่สองในประเทศไทย มาพร้อมกลุ่มผลิตภัณฑ์หลากหลายเพื่อรองรับ Generative AI และโซลูชันเฉพาะทางสำหรับแต่ละอุตสาหกรรม

เพิ่มประสิทธิภาพการดำเนินงานให้กับลูกค้าในประเทศไทย ในวงการฟินเทค สื่อ เทคโนโลยี และค้าปลีก

อาลีบาบา คลาวด์ ธุรกิจด้านเทคโนโลยีดิจิทัลและหน่วยงานหลักด้านอินเทลลิเจนซ์ของอาลีบาบา กรุ๊ป ประกาศเปิดตัวดาต้าเซ็นเตอร์แห่งที่สองในประเทศไทย มุ่งเพิ่มสมรรถนะในการตอบสนองความต้องการบริการคลาวด์คอมพิวติ้งที่เพิ่มขึ้นในประเทศไทย โดยเฉพาะเพื่อรองรับแอปพลิเคชัน generative AI และสนับสนุนนโยบายของรัฐบาลไทยที่มุ่งส่งเสริมนวัตกรรมดิจิทัลและการพัฒนาเทคโนโลยีที่นำสู่ความยั่งยืน

นาย ฌอน หยวน รองประธานฝ่ายธุรกิจระหว่างประเทศ และ ผู้จัดการทั่วไปประจำประเทศไทย อินโดนีเซีย ญี่ปุ่น ฟิลิปปินส์ และภูมิภาคแปซิฟิกใต้ ของอาลีบาบา คลาวด์ อินเทลลิเจนซ์ กล่าวว่า “ดาต้าเซ็นเตอร์ล่าสุดของเรานี้ เป็นการเสริมแกร่งความมุ่งมั่นของเราในการให้บริการคลาวด์ที่เชื่อถือได้ ปลอดภัย และทรงประสิทธิภาพ ที่ปรับให้ตรงตามความต้องการของธุรกิจในประเทศไทย เราเพิ่มประสิทธิภาพให้กับโครงสร้างพื้นฐานในประเทศเพื่อมุ่งเสริมศักยภาพให้องค์กรในการใช้ศักยภาพของเทคโนโลยีคลาวด์ให้ได้สูงสุด โดยเฉพาะกับแอปพลิเคชัน generative AI”

ดาต้าเซ็นเตอร์ใหม่นี้ ตอกย้ำจุดยืนที่มั่นคงในฐานะผู้ให้บริการคลาวด์ระดับแนวหน้าในเอเชียตะวันออกเฉียงใต้ของอาลีบาบา คลาวด์ ด้วย availability zone ทั้งหมด 86 แห่ง ใน 28 ภูมิภาคทั่วโลก ทั้งนี้ อาลีบาบา คลาวด์ ได้เปิดดาต้าเซ็นเตอร์แห่งแรกในประเทศไทยเมื่อปี 2565

อาลีบาบา คลาวด์ ได้รับการรับรองด้านความปลอดภัยและการปฏิบัติตามกฎระเบียบมากกว่า 140 รายการจากทั่วโลก จึงมั่นใจได้ว่าผลิตภัณฑ์และบริการคลาวด์ที่บริษัทฯ นำเสนอนั้นมีความยืดหยุ่นและมีการป้องกันระดับสูงสุด ดาต้าเซ็นเตอร์สองแห่งนี้จะช่วยสนับสนุนให้อาลีบาบา คลาวด์ สามารถให้บริการผลิตภัณฑ์คลาวด์คอมพิวติ้งที่มีความพร้อมใช้สูง มีความสามารถในการสเกล และยืดหยุ่น ที่มาพร้อมความสามารถในการกู้คืนระบบจากความเสียหายที่ได้รับการเพิ่มประสิทธิภาพแล้ว และปรับให้เหมาะกับภูมิทัศน์ดิจิทัลที่ไดนามิกของประเทศ ในขณะเดียวกันก็ยังคงยึดมั่นในมาตรฐานด้านความปลอดภัยและกฎระเบียบอย่างรัดกุมเข้มงวด

โซลูชันที่เป็นนวัตกรรม เสริมศักยภาพให้ธุรกิจในประเทศ

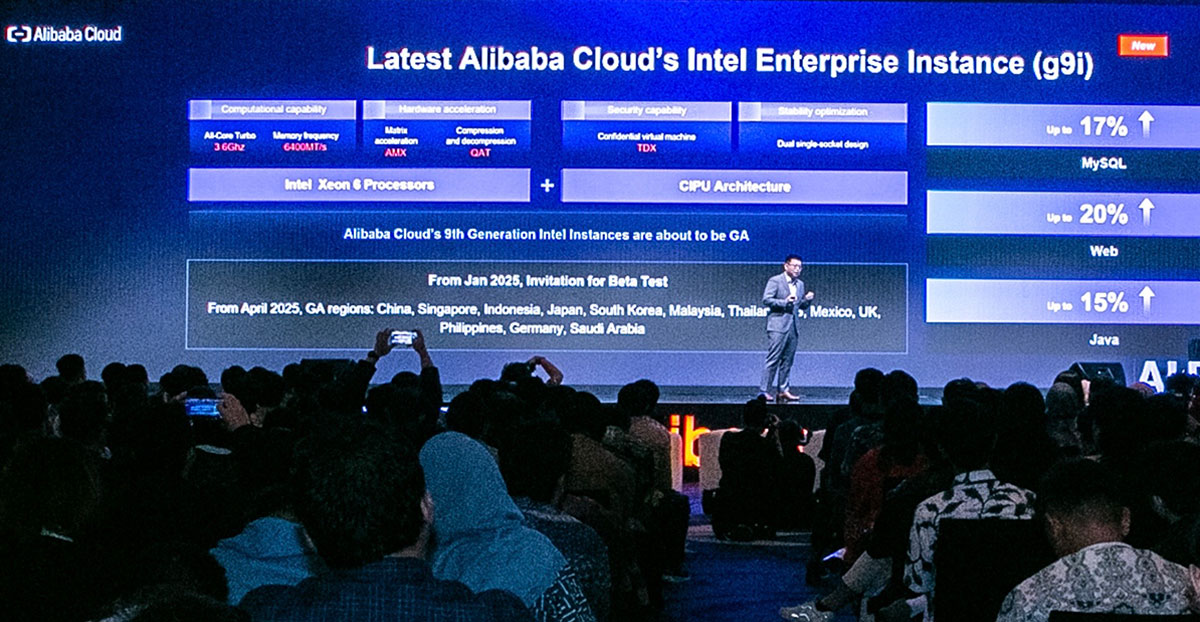

อาลีบาบา คลาวด์ มุ่งมั่นเพิ่มขีดความสามารถให้องค์กรธุรกิจในประเทศไทย ด้วยการปรับปรุงกลุ่มผลิตภัณฑ์หลากหลาย ซึ่งรวมถึง การประมวลผลแบบยืดหยุ่น (elastic computing), สตอเรจ, ฐานข้อมูล, ความปลอดภัย, ผลิตภัณฑ์ด้านเน็ตเวิร์ก, การวิเคราะห์ข้อมูล และบริการด้าน AI ต่าง ๆ รวมถึงโซลูชันต่าง ๆ ที่สามารถขจัดความท้าทายให้กับอุตสาหกรรมแต่ละประเภท

Cloud-native vector engine ของ AnalyticDB ช่วยให้ธุรกิจไทยโดยเฉพาะฟินเทคและค้าปลีก สร้างโซลูชันที่สามารถดึงข้อมูลองค์ความรู้ที่เกี่ยวข้องได้แบบเรียลไทม์ (retrieval-augmented generation:RAG) ช่วยเพิ่มประสิทธิภาพด้านการปฏิสัมพันธ์กับลูกค้า ผ่านแอปพลิเคชันที่เป็นโมเดลภาษาขนาดใหญ่ (LLM) ที่ได้รับการปรับแต่งให้เหมาะสมกับธุรกิจนั้น ๆ ความสามารถดังกล่าวจะช่วยให้บริษัทต่าง ๆ สร้างฐานความรู้เฉพาะของตน และจัดการข้อมูลทั้งที่มีโครงสร้างและไม่มีโครงสร้างในรูปแบบเวกเตอร์ได้อย่างมีประสิทธิภาพ ส่งผลให้สามารถพัฒนาแชทบอทที่ตรงตามความต้องการของตน และพัฒนาครื่องมือสำหรับการปฏิสัมพันธ์ ที่สามารถถามตอบได้อย่างชาญฉลาด และให้คำแนะนำผลิตภัณฑ์ที่เฉพาะเจาะจงกับความต้องการของแต่ละองค์กรได้ นับเป็นการยกระดับประสบการณ์ลูกค้าได้อย่างมาก

เร็ว ๆ นี้ บริษัทฯ ได้เปิดตัว Alibaba Cloud Container Compute Service (ACS) ที่มีคุณสมบัติในการลดความยุ่งยากและเพิ่มประสิทธิภาพให้กับการใช้เวิร์กโหลดด้วยการใช้ Kubernetes เป็นอินเทอร์เฟซ มาพร้อมสภาพแวดล้อมคอนเทนเนอร์ที่ไม่ต้องพึ่งพาเซิร์ฟเวอร์ ACS ช่วยให้ธุรกิจปรับขนาดการทำงานได้อย่างมีประสิทธิภาพ ด้วยการลดความซับซ้อนที่เกี่ยวกับการจัดการโครงสร้างพื้นฐานให้เหลือน้อยที่สุด เพื่อให้บุคลากรสามารถโฟกัสงานที่เป็นนวัตกรรมได้ ทั้งยังจัดการค่าใช้จ่ายได้อย่างมีประสิทธิภาพ

อาลีบาบา คลาวด์ นำเสนอโซลูชันหลากหลายที่ปรับให้เหมาะเฉพาะกับแต่ละอุตสาหกรรม และความต้องการของลูกค้าที่ใช้ดิจิทัลเป็นพื้นฐานในหลายภาคส่วน เช่น ฟินเทค ค้าปลีก และ บริการสาธารณะ โซลูชันเหล่านี้ประกอบด้วย Workspace Elastic Desktop Service (EDS), โซลูชัน eKYC ต่าง ๆ, สมรรถนะในการพัฒนา SuperApp และโซลูชันด้านความยั่งยืนที่ขับเคลื่อนด้วย AI

ให้การสนับสนุนลูกค้าหลากหลายในประเทศไทย

อาลีบาบา คลาวด์ มีบทบาทสำคัญในการสนับสนุนธุรกิจไทยหลายภาคส่วน ซึ่งรวมถึงเทคโนโลยี สื่อ ค้าปลีก ฟินเทค และภาครัฐ โซลูชันคลาวด์ที่ปรับขนาดได้ ปลอดภัย และเป็นการสร้างสรรค์ใหม่ของอาลีบาบา คลาวด์ ช่วยเสริมให้องค์กรต่าง ๆ สามารถเพิ่มประสิทธิภาพในการทำงาน เร่งการเปลี่ยนผ่านสู่ดิจิทัล และให้บริการลูกค้าของตนได้ดีขึ้น

ทรู ดิจิทัล กรุ๊ป หนึ่งในธุรกิจหลักของบริษัท ทรู คอร์ปอเรชั่น จำกัด (มหาชน) ซึ่งเป็นบริษัทด้านเทคโนโลยีโทรคมนาคมระดับแนวหน้าแห่งหนึ่งของไทย ใช้ประโยชน์จากผลิตภัณฑ์คลาวด์คอมพิวติ้งที่เชื่อถือได้และพิสูจน์ประสิทธิภาพแล้วของอาลีบาบา คลาวด์ โดยเฉพาะเทคโนโลยีด้านฐานข้อมูลและคอนเทนเนอร์ เพื่อเพิ่มประสิทธิภาพ ความเสถียร และเพิ่มความสามารถในการปรับขนาดการทำงานของแพลตฟอร์มด้านพลังงานของบริษัทฯ

เยลล์ กรุ๊ป บริษัทด้านดิจิทัลครีเอทีฟชั้นนำที่มีสำนักงานใหญ่ในประเทศไทย ร่วมมือกับอาลีบาบา คลาวด์ เพื่อเพิ่มประสิทธิภาพให้กับ AI-Deate ซึ่งเป็นแพลตฟอร์มสตอรี่บอร์ดที่ใช้ AI ความร่วมมือนี้มุ่งปฏิวัติเวิร์กโฟลว์เชิงสร้างสรรค์ โดยใช้เทคโนโลยี generative AI เสริมศักยภาพให้กับนักสร้างสรรค์ใน 102 ประเทศ ในการพัฒนาแอปพลิเคชันด้วยเทคโนโลยีใหม่ ๆ พร้อมจัดการความท้าทายในการสร้างสมดุลระหว่างการใช้ชีวิตและการทำงานในยุคดิจิทัล

นายดิศรา อุดมเดช ประธานเจ้าหน้าที่บริหาร เยลล์ กรุ๊ป กล่าวว่า “ความร่วมมือเชิงกลยุทธ์กับอาลีบาบา คลาวด์ ในครั้งนี้ช่วยให้เราใช้ประโยชน์จากความสามารถที่ล้ำหน้าของ AI และเปลี่ยนวิธีที่เราใช้เสริมพลังให้งานครีเอทีฟต่าง ๆ เราจะร่วมกันกำหนดนิยามใหม่ให้กับงานด้านความคิดสร้างสรรค์ทั่วทั้งเอเชียและที่อื่น ๆ”

โคเดียม บริษัทซอฟต์แวร์ชั้นนำในประเทศไทยที่เชี่ยวชาญด้านโซลูชันสำหรับสถานที่ทำงานดิจิทัล ร่วมมือกับอาลีบาบา คลาวด์ เพื่อใช้ประโยชน์จากโครงสร้างพื้นฐานที่ปรับขนาดการใช้งานได้ โดยมุ่งสร้างรากฐานดิจิทัลให้กับธุรกิจต่าง ๆ ในประเทศไทย และเพิ่มประสิทธิภาพระบบนิเวศคลาวด์ในประเทศ ผ่านบริการคลาวด์ที่เข้าถึงได้และสนับสนุนลูกค้าคนไทยอย่างครอบคลุม

นายศิวบุธ อัมพุช ซีอีโอของโคเดียม กล่าวว่า “ความร่วมมือกับอาลีบาบา คลาวด์ ช่วยให้เรามอบโซลูชันที่ทำงานดิจิทัลที่ปรับขนาดได้และยืดหยุ่นให้ลูกค้าของเราได้ โครงสร้างพื้นฐานของอาลีบาบา คลาวด์ ไม่เพียงสนับสนุนการเติบโตของเรา แต่ยังช่วยให้เราสามารถให้บริการลูกค้าธุรกิจไทยที่มีความต้องการอย่างเฉพาะเจาะจงได้อย่างมีประสิทธิภาพ”

ไวท์แชนแนล ผู้ให้บริการโทรทัศน์และ OTT ที่มีชื่อเสียงในประเทศไทย ได้เพิ่มประสิทธิภาพให้กับแพลตฟอร์มวิดีโอออนดีมานด์ ด้วยการใช้บริการสตรีมมิ่งวิดีโอครบวงจรของอาลีบาบา คลาวด์ ซึ่งช่วยให้ไวท์แชนแนลสามารถให้บริการการเล่นวิดีโอที่มีคุณภาพสูงโดยไม่มีการหน่วงเวลา โดยใช้เครือข่าย CDN ระดับโลกและโซลูชันด้านการจัดเก็บข้อมูลที่ปรับขนาดการใช้งานได้ เพื่อจัดการคอนเทนต์ไลบรารีได้อย่างมีประสิทธิภาพ แม้ในช่วงที่มีการรับส่งข้อมูลในปริมาณมากขึ้น

นายชวลิต เอื้อเฟื้อ หัวหน้าฝ่ายไอที ของไวท์แชนแนล กล่าวว่า “การทำงานร่วมกับอาลีบาบา คลาวด์ ได้ช่วยเพิ่มความสามารถของเราในการให้บริการวิดีโอไปยังผู้ชมอย่างราบรื่นเป็นอย่างมาก เทคโนโลยีล้ำสมัยของอาลีบาบา คลาวด์ ช่วยให้เรามั่นใจว่า ผู้ชมของเราจะได้รับคอนเทนต์ที่มีคุณภาพสูงทุกที่ทุกเวลา”

เสริมศักยภาพระบบนิเวศและความสามารถด้านดิจิทัลให้กับประเทศ

อาลีบาบา คลาวด์ ดูแลระบบนิเวศในไทยอย่างเข้มแข็ง ด้วยการร่วมมือกับพันธมิตรในประเทศประมาณ 70 ราย ในจำนวนนี้รวมถึง Cloud HM, Kaopanwa, Softdebut, Thai Data Cloud และ True IDC เพื่อเสริมศักยภาพให้กับการเปลี่ยนผ่านสู่ดิจิทัลของธุรกิจทั่วประเทศไทย

อาลีบาบา คลาวด์ มุ่งมั่นส่งเสริมผู้มีความสามารถด้านดิจิทัล ผ่านความร่วมมือกับมหาวิทยาลัยต่าง ๆ ของไทย เช่น จุฬาลงกรณ์มหาวิทยาลัย มหาวิทยาลัยเทคโนโลยีพระจอมเกล้าธนบุรี มหาวิทยาลัยสงขลานครินทร์ และ มหาวิทยาลัยกรุงเทพ โดยนำเสนอเวิร์กช็อปและหลักสูตรคลาวด์คอมพิวติ้งและ generative AI ที่มีการให้การรับรองเมื่อผ่านหลักสูตร เมื่อปลายปี 2566 อาลีบาบา คลาวด์ ได้เปิดตัว global skills center แห่งแรกที่จุฬาลงกรณ์มหาวิทยาลัย โดยให้บริการหลักสูตรฝึกอบรม บูธแคมป์ การแข่งขันด้าน AI และโปรแกรมพัฒนาความเป็นผู้นำ โดยไม่มีค่าใช้จ่าย โครงการเหล่านี้เป็นส่วนหนึ่งของความพยายามอย่างต่อเนื่องของอาลีบาบา คลาวด์ ในการเพิ่มประสิทธิภาพทรัพยากรทางการศึกษาและส่งเสริมแลนด์สเคปดิจิทัลที่รุ่งเรืองผ่านความร่วมมือกับสถาบันในประเทศต่าง ๆ