ผลสำรวจพบธุรกิจส่วนใหญ่ทึ่งในศักยภาพของ AI ที่จะช่วยให้บรรลุเป้าหมายด้านความยั่งยืน แต่ยังกังวลเรื่องการใช้พลังงาน

- องค์กรมากกว่าหนึ่งในสองยอมรับว่ามีช่องว่างของความเข้าใจว่าเทคโนโลยีดิจิทัลจะช่วยให้บรรลุเป้าหมายด้านความยั่งยืนได้อย่างไร

- ตลาดเอเชียเป็นตลาดนำในการใช้ AI คลาวด์คอมพิวติ้ง และใช้ดิจิทัลเทคโนโลยีขับเคลื่อนความยั่งยืน โดยผลสำรวจพบประเทศไทยอยู่ในลำดับต้น ๆ ในการใช้ AI และคลาวด์คอมพิวติ้ง

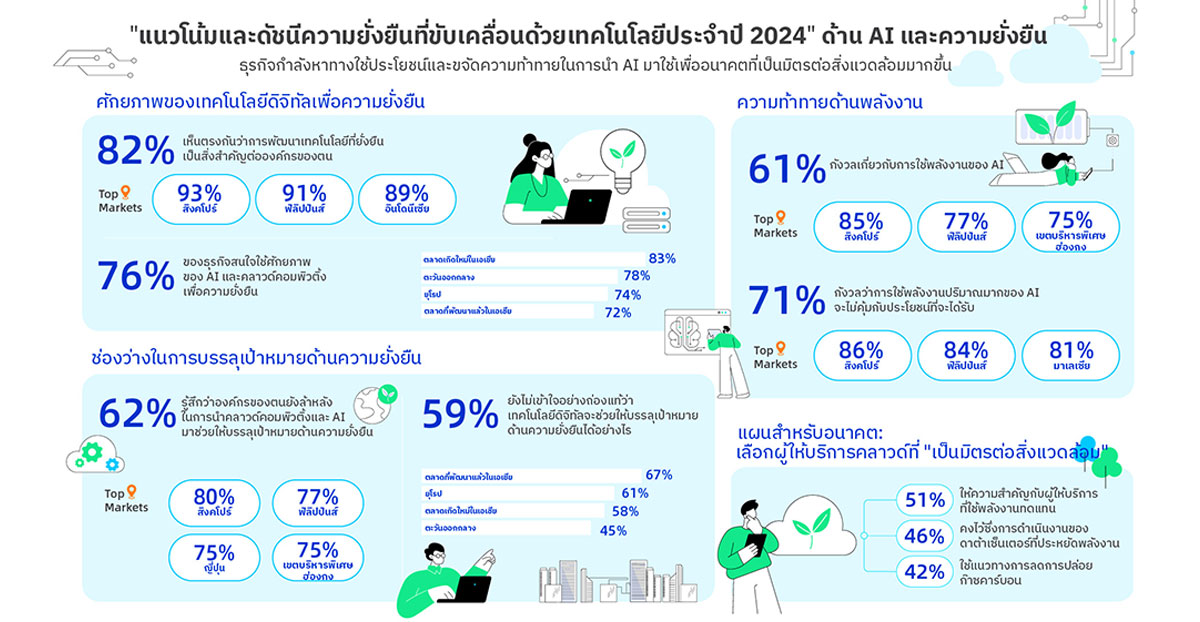

อาลีบาบา คลาวด์ ธุรกิจด้านเทคโนโลยีดิจิทัลและหน่วยงานหลักด้านอินเทลลิเจนซ์ของอาลีบาบา กรุ๊ป เผยรายงาน “แนวโน้มและดัชนีความยั่งยืนที่ขับเคลื่อนด้วยเทคโนโลยีประจำปี 2024” (Tech-Driven Sustainability Trends and Index 2024) พบว่าธุรกิจมากกว่าสามในสี่ (76%) ในเอเชีย ยุโรป และตะวันออกกลางตระหนักว่าเทคโนโลยีดิจิทัลต่าง ๆ รวมถึงปัญญาประดิษฐ์ (AI) และคลาวด์คอมพิวติ้ง มีศักยภาพสูงในการขับเคลื่อนการพัฒนาที่ยั่งยืน อย่างไรก็ตาม 61% ของผู้ตอบแบบสอบถามยังคงกังวลว่าการที่เทคโนโลยีเหล่านี้ใช้พลังงานมากจะเป็นอุปสรรคสำคัญต่อการนำเทคโนโลยีเหล่านี้ไปใช้อย่างแพร่หลาย

การให้ความสำคัญกับการนำศักยภาพของ AI คลาวด์คอมพิวติ้ง และเทคโนโลยีดิจิทัลขั้นสูงอื่น ๆ เพื่อสนับสนุนการพัฒนาที่ยั่งยืนในภูมิภาคต่าง ๆ นั้นแตกต่างกัน ผลสำรวจพบว่า ตลาดเกิดใหม่ในเอเชียเป็นผู้นำในเรื่องนี้ (83%) ตามติดด้วยตลาดตะวันออกกลาง (78%) ยุโรป (74%) และตลาดที่พัฒนาแล้วในเอเชีย (72%) หากลงรายละเอียดระดับประเทศ ตลาดที่ให้ความสนใจและให้ความสำคัญด้านนี้มากที่สุดคือฟิลิปปินส์ (91%) สิงคโปร์ (84%) อินโดนีเซีย (81%) และไทย (81%)

นอกจากนี้ผู้ตอบแบบสำรวจโดยเฉลี่ย 80% ได้กำหนดเป้าหมายด้านความยั่งยืนไว้แล้ว โดยประเทศไทยสูงกว่าผลเฉลี่ยเล็กน้อยอยู่ที่ 82%

ความแตกต่างในการใช้ AI และความพยายามด้านความยั่งยืนของแต่ละภูมิภาค

แม้การนำเทคโนโลยีดิจิทัลมาใช้จะเป็นไปในเชิงบวก แต่ธุรกิจ 59% ยังไม่เข้าใจอย่างถ่องแท้ว่าเทคโนโลยีดิจิทัลจะช่วยให้บรรลุเป้าหมายด้านความยั่งยืนได้อย่างไร โดยตลาดเอเชียมีช่องว่างด้านนี้มากที่สุดที่ 63% ตามด้วยยุโรป 61% และตะวันออกกลาง 45% ในเอเชียประเทศไทยอยู่ในลำดับที่สาม (70%) รองจากสิงคโปร์ (83%) และเขตบริหารพิเศษฮ่องกง (75%)

นอกจากนี้ผู้ตอบแบบสำรวจประมาณสองในสาม (62%) เชื่อว่าองค์กรของตนยังล้าหลังในการนำคลาวด์คอมพิวติ้งและ AI มาปรับใช้เพื่อเร่งให้บรรลุเป้าหมายด้านความยั่งยืนได้เร็วขึ้น ข้อกังวลนี้มีเปอร์เซ็นที่สูงในประเทศสิงคโปร์ (80%) ฟิลิปปินส์ (77%) ญี่ปุ่น (75%) และเขตบริหารพิเศษฮ่องกง (75%) ซึ่งบ่งชี้ถึงความจำเป็นเร่งด่วนที่องค์กรต่างต้องเร่งนำเทคโนโลยีมาใช้เพื่อเพิ่มศักยภาพในการพัฒนาความยั่งยืน

โดยภาพรวม ธุรกิจ 82% เห็นตรงกันว่าการพัฒนาเทคโนโลยีที่ยั่งยืน เป็นสิ่งสำคัญต่อบริษัทของตน โดยสิงคโปร์ (93%) ฟิลิปปินส์ (91%) และอินโดนีเซีย (89%) เป็นสามประเทศที่มีสัดส่วนสูง คุณประโยชน์หลากหลายของการใช้เทคโนโลยีดิจิทัลเพื่อความยั่งยืนที่องค์กรที่ตอบแบบสำรวจตระหนักมากที่สุด เช่น ประหยัดค่าใช้จ่าย เพิ่มประสิทธิภาพการดำเนินงาน และสามารถปฏิบัติตามกฎระเบียบด้านสิ่งแวดล้อม สังคม และธรรมาภิบาล (ESG) ได้ดีขึ้น สำหรับประเทศไทย ผู้ตอบแบบสอบถาม 80% เห็นด้วยกับเรื่องนี้

52% ของธุรกิจในตะวันออกกลางมองว่า AI และ ML (แมชชีนเลิร์นนิ่ง) เป็นเทคโนโลยีดิจิทัลที่สำคัญที่สุดสำหรับการพัฒนาความยั่งยืนขององค์กร ในขณะที่ยุโรปให้ความสำคัญเรื่องนี้รองลงมาที่ 41% ตลาดเกิดใหม่ในเอเชีย 40% และตลาดที่พัฒนาแล้วในเอเชีย 36% ผู้ตอบแบบสำรวจในไทยระบุว่าทั้ง AI/ML และคลาวด์คอมพิวติ้งเป็นเทคโนโลยีดิจิทัลที่สำคัญที่สุด (34%) ในขณะเดียวกัน 81% ของธุรกิจที่ตอบแบบสำรวจรู้สึกว่ายังจำเป็นต้องใช้คนควบคุมและชี้แนะการพัฒนาเทคโนโลยีดิจิทัลและเครื่องมือด้าน AI ต่าง ๆ โดยตลาดตะวันออกกลาง (91%) มีแนวคิดด้านนี้สูงสุด ตามด้วยตลาดเกิดใหม่ในเอเชีย (83%) ยุโรป (82%) และตลาดพัฒนาแล้วในเอเชีย (74%)

อย่างไรก็ตาม ผู้ตอบแบบสำรวจ 61% กังวลว่าการที่เทคโนโลยีดิจิทัลใช้พลังงานปริมาณมากจะเป็นอุปสรรคต่อการนำ AI ไปใช้ในวงกว้าง โดยสิงคโปร์มีความกังวลสูงสุดที่ 85% ฟิลิปปินส์ 77% เขตบริหารพิเศษฮ่องกง 75% และไทย 65% นอกจากนี้ธุรกิจ 71% ยังเชื่อว่าการใช้พลังงานปริมาณมากของเทคโนโลยีดิจิทัลเช่น AI จะไม่คุ้มกับประโยชน์ที่จะได้รับ โดย 3 ตลาดที่กังวลเรื่องนี้สูงสุดคือสิงคโปร์ 86% ฟิลิปปินส์ 84% และมาเลเซีย 81%

รายงานฉบับนี้ยังเน้นให้เห็นความสำคัญของการเลือกผู้ให้บริการทางเทคโนโลยีที่ให้ความสำคัญกับความยั่งยืน ในมุมของการเลือกผู้ให้บริการคลาวด์ที่ “เป็นมิตรต่อสิ่งแวดล้อม” ธุรกิจประมาณครึ่งหนึ่งให้ความสำคัญกับผู้ให้บริการคลาวด์ที่ใช้พลังงานทดแทน (51%) ตามด้วยผู้ให้บริการที่คงไว้ซึ่งการดำเนินงานของดาต้าเซ็นเตอร์ที่ประหยัดพลังงาน (46%) และใช้แนวทางหรือมีโครงการลดการปล่อยก๊าซคาร์บอน (42%) ผู้ตอบแบบสำรวจในไทยให้ความสำคัญกับการเลือกผู้ให้บริการคลาวด์แตกต่างเล็กน้อย โดยจัดให้ผู้ให้บริการดาต้าเซ็นเตอร์ที่ประหยัดพลังงานอยู่ในลำดับสูงสุด (51%) ตามด้วยผู้ให้บริการที่มีความมุ่งมั่นในอนาคตเกี่ยวกับผลิตภัณฑ์และบริการที่เป็นนวัตกรรมหรือมีความยั่งยืน (41%) และผู้ให้บริการที่ใช้พลังงานทดแทนในการดำเนินงานดาต้าเซ็นเตอร์ (38%)

ความมุ่งมั่นต่อ AI ที่เป็นมิตรต่อสิ่งแวดล้อม และนวัตกรรมโอเพ่นซอร์ส

เซลิน่า หยวน ประธานฝ่ายธุรกิจระหว่างประเทศของอาลีบาบา คลาวด์ อินเทลลิเจนซ์ กล่าวว่า “การตอบแบบสำรวจของผู้มีอำนาจตัดสินใจจาก 13 ตลาด ทำให้รายงานการสำรวจนี้ให้ความกระจ่างเกี่ยวกับทัศนคติ และความท้าทายในการใช้ AI และคลาวด์คอมพิวติ้งเพื่อความยั่งยืนที่ธุรกิจเผชิญในปัจจุบัน อาลีบาบา คลาวด์ มุ่งมั่นสนับสนุนการเดินบนเส้นทางแห่งความยั่งยืนของธุรกิจต่าง ๆ ด้วยโซลูชันที่ปรับขนาดการทำงานได้และยั่งยืน AI จะกลายเป็นเครื่องมือทรงพลังที่จะช่วยเพิ่มประสิทธิภาพการใช้พลังงานให้เหมาะสม ด้วยคำมั่นของเราที่จะใช้พลังงานสะอาด 100% ภายในปี 2573 และเพิ่มประสิทธิภาพการใช้พลังงานในดาต้าเซ็นเตอร์ทั่วโลกของเรา รวมถึงการเพิ่มขีดความสามารถให้กับ Generative AI เช่น ประสิทธิภาพของโมเดลภาษาขนาดใหญ่ (LLM)”

การดำเนินงานด้านคลาวด์ที่เป็นมิตรต่อสิ่งแวดล้อมของอาลีบาบา คลาวด์ ประสบความสำเร็จอย่างสูง ข้อมูล ณ วันสิ้นสุดปีงบประมาณของบริษัทฯ เมื่อวันที่ 31 มีนาคม 2567 เผยให้เห็นว่าการใช้พลังงานเฉลี่ย (PUE) ของดาต้าเซ็นเตอร์ที่บริษัทฯ สร้างเองมีประสิทธิภาพดีขึ้นเป็น 1.200 จาก 1.215 ในปีงบประมาณก่อนหน้า โดย 56% ของการใช้ไฟฟ้ามาจากแหล่งพลังงานสะอาด นอกจากนี้โครงสร้างพื้นฐานการประมวลผลที่เป็นมิตรต่อสิ่งแวดล้อมของอาลีบาบา ยังช่วยให้ลูกค้าลดการปล่อยก๊าซเรือนกระจกได้ 9.884 ล้านตัน ซึ่งลดได้เพิ่มขึ้นอย่างน่าทึ่งถึง 44% เมื่อเทียบกับช่วงเดียวกันของปีที่ผ่านมา

นอกจากนี้ อาลีบาบา คลาวด์ ยังเป็นผู้นำในการช่วยให้การใช้ AI แพร่หลายมากขึ้น ผ่านการเปิดโอเพ่นซอร์สให้ธุรกิจทุกขนาดเข้าถึงเทคโนโลยี AI ขั้นสูงได้ด้วยค่าใช้จ่ายที่เหมาะสม อาลีบาบา คลาวด์ เสริมแกร่งให้นักพัฒนาซอฟต์แวร์สามารถสร้างแอปพลิเคชัน AI เฉพาะงานได้อย่างมีประสิทธิภาพและคุ้มค่าใช้จ่าย ด้วยการเปิดโอเพ่นซอร์สโมเดลภาษาขนาดใหญ่ที่ล้ำสมัยของบริษัทฯ ในตระกูล Qwen ซึ่งรวมถึง Qwen2.5-VL และ Qwen2.5-1M และ Tongyi Wanxiang (Wan) ซึ่งเป็นโมเดลพื้นฐานด้านวิดีโอของ บริษัทฯ โมเดลโอเพ่นซอร์สเหล่านี้ ได้สร้างแรงบันดาลใจให้เกิดการสร้างโมเดลอนุพันธ์มากกว่า 100,000 โมเดล บน Hugging Face ซึ่งเป็นการแสดงให้เห็นถึงความสามารถรอบด้านของโมเดลเหล่านี้ และการนำไปใช้แพร่หลายทั่วโลก อาลีบาบา คลาวด์ สนับสนุนโมเดลที่มีขนาดพารามิเตอร์เล็กลง เพื่อลดค่าใช้จ่ายและลดการใช้พลังงานในการฝึกอบรมและปรับใช้ AI เป็นการส่งเสริมระบบนิเวศการทำงานร่วมกันที่ขับเคลื่อนด้วยนวัตกรรมที่ประหยัดพลังงาน

รายงาน “Tech-Driven Sustainability Trends and Index 2024” ทำการสำรวจผู้มีอำนาจตัดสินใจ 1,300 รายใน 13 ตลาด มีวัตถุประสงค์เพื่อให้ข้อมูลเชิงลึกที่มีคุณประโยชน์เกี่ยวกับภูมิทัศน์การพัฒนาอย่างยั่งยืนขององค์กร รายงานการสำรวจเน้นย้ำไปที่บทบาทสำคัญของเทคโนโลยีในการขับเคลื่อนการเปลี่ยนแปลงที่สร้างผลกระทบสำคัญ และเน้นให้เห็นความจำเป็นที่ธุรกิจควรใช้ AI และคลาวด์คอมพิวติ้งอย่างมีความรับผิดชอบ เพื่อขจัดความกังวลด้านการใช้พลังงานและลดช่องว่างของการทำงานด้านความยั่งยืน

เกี่ยวกับการสำรวจ

รายงาน “Tech-Driven Sustainability Trends and Index 2024” ของอาลีบาบา คลาวด์ จัดทำโดยอิสระโดย Yonder Consulting ซึ่งเป็นบริษัทที่ปรึกษาทางธุรกิจ พร้อมด้วยการให้คำปรึกษา การออกแบบ และการวิเคราะห์จาก The Purpose Business ซึ่งเป็นบริษัทที่ปรึกษาด้านความยั่งยืน การสำรวจครั้งนี้เป็นการรวบรวมความคิดเห็นจากผู้นำธุรกิจและผู้บริหารระดับสูง 1,300 คนที่อยู่ในอุตสาหกรรมต่าง ๆ เช่น เทคโนโลยีและการสื่อสาร การเงิน โครงสร้างพื้นฐาน ทรัพยากรหมุนเวียน การดูแลสุขภาพ การขนส่ง ค้าปลีก และภาคการผลิต โดยทำการสำรวจจากวันที่ 10 พฤษภาคม ถึงวันที่ 19 มิถุนายน 2567

ผู้ตอบแบบสำรวจมาจากตลาด 13 แห่งในเอเชีย ยุโรป และ ตะวันออกกลาง ในเอเชียประกอบด้วย อินโดนีเซีย มาเลเซีย ฟิลิปปินส์ ไทย เขตบริหารพิเศษฮ่องกง ญี่ปุ่น สิงคโปร์ และเกาหลีใต้ ในยุโรปประกอบด้วย ฝรั่งเศส เยอรมนี และสหราชอาณาจักร และในตะวันออกกลางประกอบด้วย ซาอุดีอาระเบียและสหรัฐอาหรับเอมิเรตส์ คำว่าตลาดที่พัฒนาแล้วในเอเชียหมายถึง เขตบริหารพิเศษฮ่องกง ญี่ปุ่น สิงคโปร์ และเกาหลีใต้ ส่วนคำว่าตลาดเกิดใหม่ในเอเชียในที่นี้หมายถึง อินโดนีเซีย มาเลเซีย ฟิลิปปินส์ และไทย