Ericsson and depa extend strategic partnership to accelerate 5G Industrial Innovation in Thailand

- This is a two-year extension to the private-public collaboration which commenced in 2022.

- A cornerstone of the partnership is the 5G Innovation and Experience Studio in Thailand Digital Valley.

- Ericsson will deliver advanced, secure and resilient 5G solutions to accelerate industrial digitalization in support of the Thailand 4.0 vision.

Ericsson (NASDAQ: ERIC) and the Digital Economy Promotion Agency (depa) have extended their strategic Memorandum of Understanding (MoU) to jointly advance the deployment and understanding of 5G technologies across Thailand’s industrial landscape.

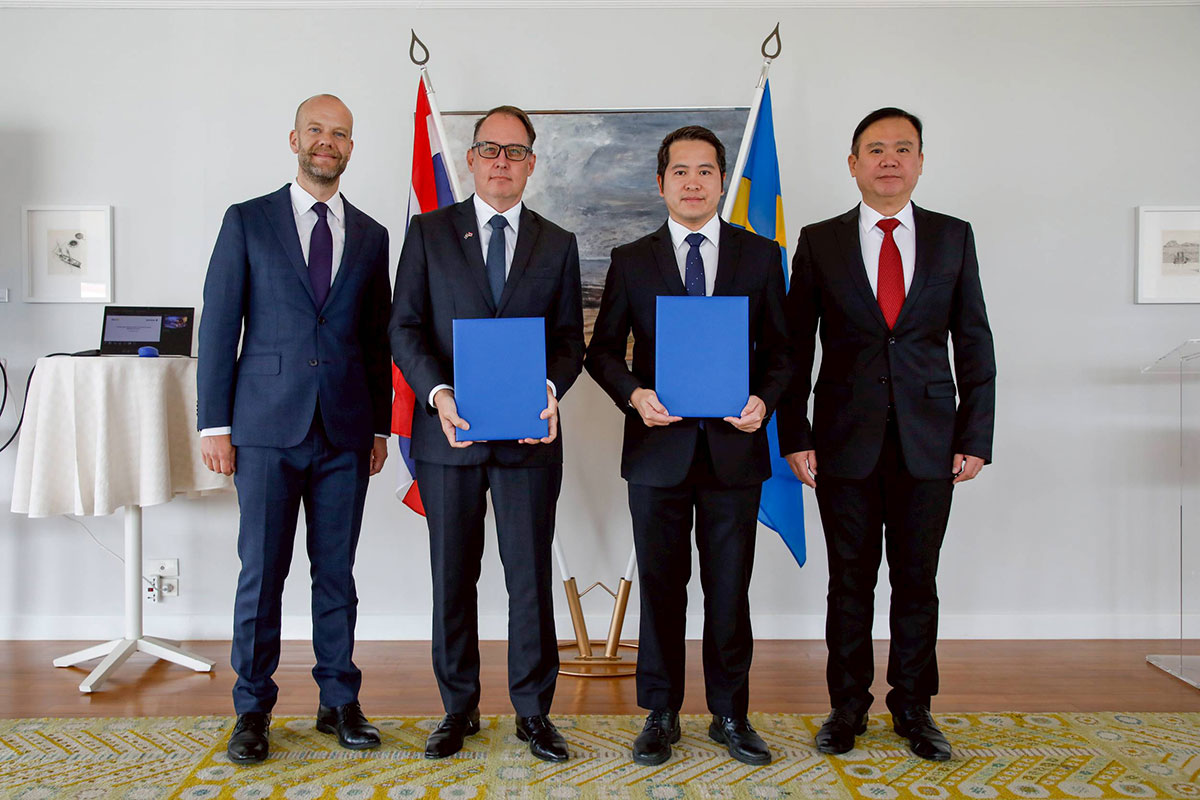

The signing ceremony was attended by executives from both organizations, including Dr. Warin Ratchananusorn, Acting Senior Executive Vice President of depa, Dr. Supakorn Siddhichai, Group Executive Vice President of depa, and Mr. Anders Rian, President of Ericsson Thailand. The Ministry of Digital Economy and Society (MDES) was represented at the event by its Deputy Permanent Secretary, Dr. Nattapon Nattasomboon. Mr. Per Linnér, the Swedish Embassy’s Chargé d’affaires also attended the event .

This two-year extension of the collaboration, which commenced in 2022, underscores a shared commitment to drive digital transformation and innovation in alignment with the country’s Thailand 4.0 vision.

A cornerstone of this partnership has been the establishment of the 5G Innovation and Experience Studio (5GIX Studio), located within Thailand Digital Valley in Chonburi province. Designed as a testbed and service hub, the studio facilitates trials of next-generation wireless and network technologies, spectrum sharing, and the development of cutting-edge applications tailored to Thailand’s evolving digital economy.

Since the establishment of the 5GIX Studio, a broad range of technology ecosystem partners have collaborated to develop and test innovative 5G applications, including robotics, automated machines, and advanced security camera solutions.

According to MDES, Thailand’s enterprise 5G market is projected to exceed USD 2.5 billion by 2027, driven by demand in manufacturing, logistics, energy, and smart city development, with over 70% of Thai enterprises expected to adopt digital technologies by 2026.

“Ericsson remains committed to supporting Thailand’s journey toward becoming a digital society under the Thailand 4.0 vision,” said Mr. Anders Rian, President of Ericsson Thailand. “Leveraging our global expertise and advanced, secure and resilient 5G solutions, we aim to help build a robust and inclusive 5G ecosystem that empowers industries across the nation and encourages further investment in Thailand.”

Asst.Prof.Dr. Nuttapon Nimmanphatcharin, President & CEO of depa, added, “Ericsson is a strategic partner in our mission to strengthen Thailand’s digital economy. Together, we will work with industry stakeholders to develop forward-looking strategies and foster innovations that enhance quality of life and national competitiveness.”

Mr. Per Linnér, the Swedish Embassy’s Chargé d’affaires spoke about the longstanding and growing trade and innovation ties between Sweden and Thailand, underscoring the importance of cross-border collaboration in advancing digital transformation.

“Last week, Sweden and Thailand elevated our bilateral relations to a Strategic Partnership. This landmark agreement was signed by our respective foreign ministers and sets out our shared ambition to deepen cooperation in key areas such as sustainable development, green transition, defense, innovation — and importantly — digitalization,” said Mr. Linnér.

“Sweden and Thailand will cooperate around telecommunications, critical infrastructure including 5G, resilient and trusted supply chains, cybersecurity and in safeguarding the free, open, global interoperable and secure internet. The MoU signing between Ericsson and DEPA is a perfect example of how that vision is already being translated into action,“ he added.

The collaboration will encompass knowledge exchange on digital economy policies, best practices, and innovation strategies. Both organizations will jointly explore emerging technologies and use cases through the 5GIX platform, while also supporting Thailand’s digital development goals.

Ericsson is a global leader in 5G and powers 187 live networks across countries. It is recognized as an industry leader having recently topped the Frost Radar™: Global 5G Network Infrastructure Market ranking for the second year in a row. Ericsson has also secured the highest ranking in the recently published Omdia Market Landscape RAN Vendors report for 2025. This recognition highlights Ericsson’s leadership in both business performance and portfolio, underscoring its commitment to innovation and excellence in the industry.